谈球吧·(中国)-官方电子元件有限公司欢迎您!

谈球吧谈球吧Ampere表示,过去几年里一直专注于为各种类型的云端工作负载和基础设施开发的创新技术,由于通用和人工智能(AI)工作负载正在云中迅速融合到AI计算中,因此未来的平台必须包括以下特性,分别是:

当以上要求结合Ampere的技术,包括定制内核、专有网格、小芯片互联等,再加入自身的AI加速时,就诞生了性的AmpereOne Aurora。其主要特点包括以下几点:

Ampere称,该产品可以在一系列AI推理和训练用例中进行扩展,具有强大的AI计算功能,适用于RAG和矢量数据库等工作负载,为AI计算提供领先的每机架性能。更重要的是,AmpereOne Aurora可以采用风冷散热,这意味着可以部署在全球任何现有的数据中心。

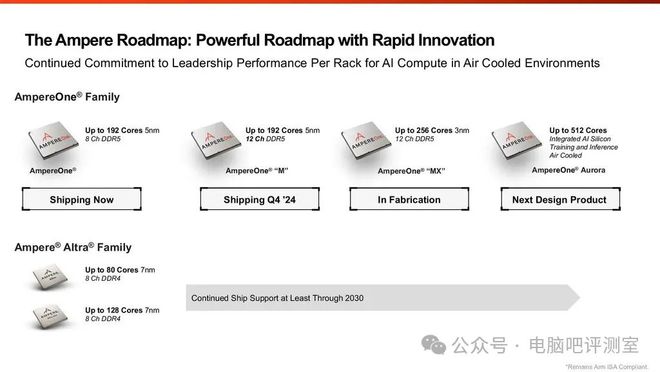

展望2024年第四季度,Ampere计划推出AmpereOne M系列,核心数量仍然保持在192个,不过会引入到12通道DDR5的平台上。到了2025年,Ampere将带来增强版本,将处理器的核心数量提高到256个,并改用3nm工艺制造,以进一步提升性能。

AmpereOne系列作为Ampere公司旗下主打的ARM架构专业处理器,也在这个AI时代带来了新产品——AmpereOne Aurora。按照Ampere公司的描述,新的产品将会对AI有更优秀的支持,且本身核心数等硬性规格也是进一步提升了,其传统运算性能的提升也是不小。另外,Ampere前期曾公布与高通合作优化能耗,不知道是否有成效了,或许真能成为取代NVIDIA的通用AI芯片的新选择也说不定??

根据wccftech 报道 ,印度汽车制造商Ola在近日宣布,它们将在2026年之前设计、制造并推出Bodhi系列AI芯片,这些芯片将采用 ARM架构 。报道文章称,Ola的首席执行官Bhavish Aggarwal说道,印度需要自主探索人工智能领域及研发相关产品,而不是依赖第三方替代品。

此外,报道文章还提到Ola目前已展示了Bodhi系列的部分AI芯片,以及Sarv-1云原生CPU和Ojas边缘AI芯片。其中Bodhi-1 AI芯片预计在2026年发布,Ola称该产品专为大规模LLM设计,将拥有“最佳的能效表现”,旨在迎合AI细分市场的大部分需求,同时其下一代产品Bodhi-2预计在2028年发布,Ola称Bodhi-2是一款对标业界芯片推出的产品,性能和能效方面将优于英伟达的GPU(未表明具体型号),额定功耗为200W。而Sarv-1芯片,Ola称这是一款云原生芯片,是一款基于ARM 指令集 的通用服务器CPU,专为云计算领域设计,同时有传闻称Sarv-1可能采用ARM Neoverse N3内核。至于Ojas边缘AI芯片,Ola则表示该系列芯片将集成到自家的下一代电动汽车中,以帮助其运行充电、ADAS等系统,同时该系列芯片将通过AI原生架构支持广泛的生态系统。

至于在代工方面,Bhavish Aggarwal声称他们将与全球一级或二级代工厂合作,可能是台积电或三星。

印度的第一颗AI芯片正式宣布了,印度汽车制造商Ola正式推出,其实汽车厂商搞芯片也不算奇怪,毕竟有需求就有动力,特斯拉不也是这样吗?不过印度这个国家的科技产品总给人一些不靠谱的感觉……再加上这次更是直接高调宣布性能与能效优于英伟达GPU,值得一提的是,Ola在不久前刚刚完成了全印度最大的IPO,此次的芯片发布或许将进一步推动股价。

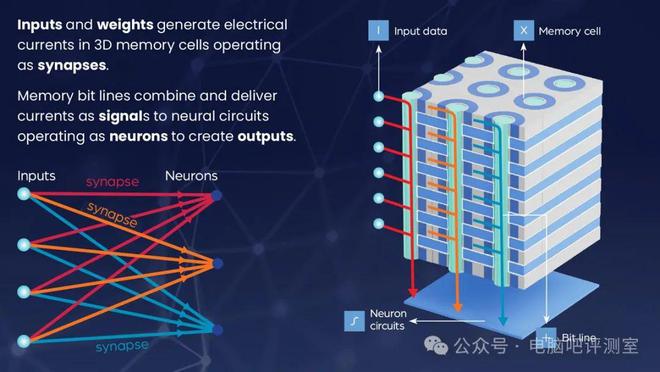

近日,NEO Semiconductor 公布 了3D X-AI芯片技术,以取代目前用于AI GPU的HBM。这款3D DRAM内置AI处理功能,可以处理和生成不需要数学计算的输出。当大量数据在内存和处理器之间传输时芯片发布网,可以缓解数据总线的瓶颈问题,提高了AI性能和效率。

NEO Semiconductor创始人兼首席执行官Andy Hsu表示:“由于架构和技术效率低下,目前的AI芯片浪费了大量的性能和功率。目前的AI芯片架构将数据存储在HBM中,并依赖GPU来执行所有计算。这种分离的数据存储和数据处理体系结构,使得数据总线成为不可避免的性能瓶颈。通过数据总线传输大量的数据会导致性能受限,而且功耗非常高。3D X-AI可以在每个HBM芯片上进行AI处理。这可以大大减少HBM和GPU之间的数据传输,从而提高性能并显着降低功耗。”

3D X-AI芯片的底部有一个神经元电路层,用于处理存储在同一芯片上的300个存储层中的数据。该3D DRAM中有8000个神经路电路,在存储器中进行AI处理,相比传统方案性能提高了100倍。其容量为128GB,每个芯片可以支持10TB/s的AI处理速度。如果将12个芯片堆叠在一个HBM封装堆栈中,可以实现1.5TB以上的存储容量以及120TB/s的处理吞吐量。

按照NEO Semiconductor说法,采用3D X-AI技术的芯片在存储密度上是当前HBM产品的八倍,更重要的是,通过减少高能耗GPU需要处理的数据量,使得降低99%的功耗。

除了NVIDIA是在所有AI芯片厂商面前的一座大山外,HBM内存也成为绕不过的门槛,但真的绕不过吗?先前三星曾经宣布过一款使用LPDDR内存的轻量AI芯片,而NEO Semiconductor本次公布3D X-AI芯片才是真正的能够取代HBM的新选择。按照介绍,通过3D X-AI芯片技术可以提高AI性能,相当于是对AI特化的内存芯片优化技术。只是我有个疑问,如果这项技术能应用于普通DRAM内存,那岂不是同样也能用于HBM内存吗?届时大家都更强了,最高性能的AI芯片岂不是还是一样选择HBM内存?不知道我的设想是否可能。

Copyright © 2005-2024 谈球吧·(中国)-官方网站 版权所有 非商用版本